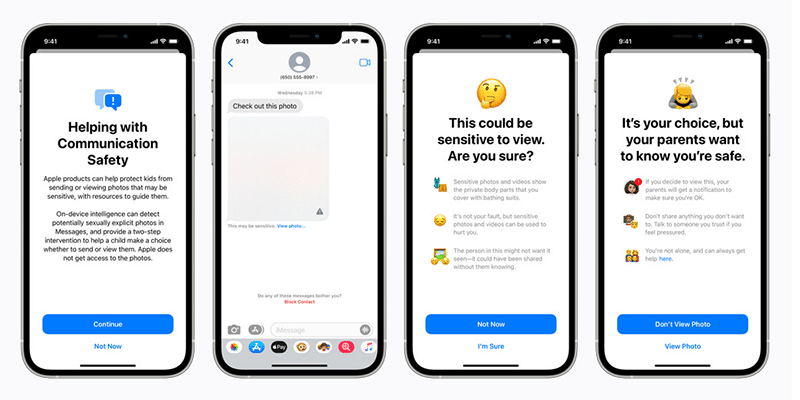

Apple เตรียมปล่อยฟีเจอร์ Child Safety ที่จะนำมาใช้งานจริงในช่วงปลายปีนี้ โดยฟีเจอร์ดังกล่าวจะเป็นการตรวจจับภาพอนาจารหรือการล่วงละเมิงทางเพศเด็ก

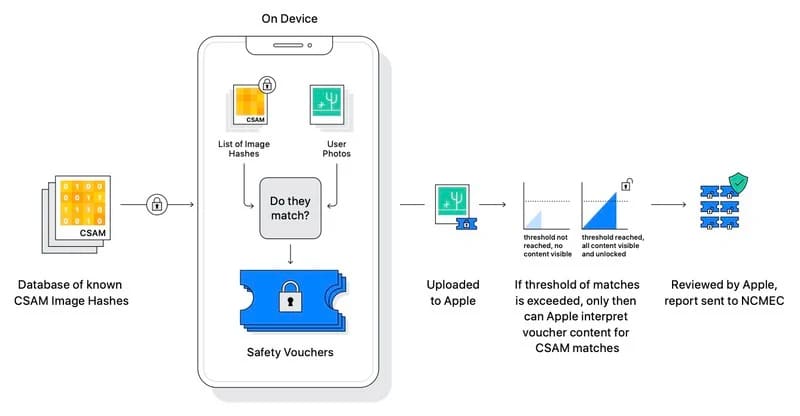

ฟีเจอร์นี้จะเป็นการใช้การสแกนรูปภาพของสื่อการล่วงละเมิดทางเพศเด็กหรือ Child Sexual Abuse Material (CSAM) ที่อยู่ในเครื่องและเปิด iCloud Photos ไว้ (แต่จะใช้งานไม่ได้หากปิด iCloud Photos) ซึ่งหากภาพต่างๆ จะถูกสแกนและวิเคราะห์บนฐานข้อมูล CSAM พร้อมใช้เทคโนโลยี NeuralHash เข้ามาช่วย

สำหรับฟีเจอร์ดังกล่าวจะถูกใช้งานในระบบปฏิบัติการ iOS 15, iPadOS 15 และ macOS Monterey ที่จะปล่อยตัวเต็มในช่วงปลายปีนี้ และจะเริ่มใช้งานในประเทศสหรัฐฯ เป็นที่แรกหลังเปิดตัว ซึ่งจะทยอยใช้งานในประเทศอื่นๆ ในเวลาต่อมา

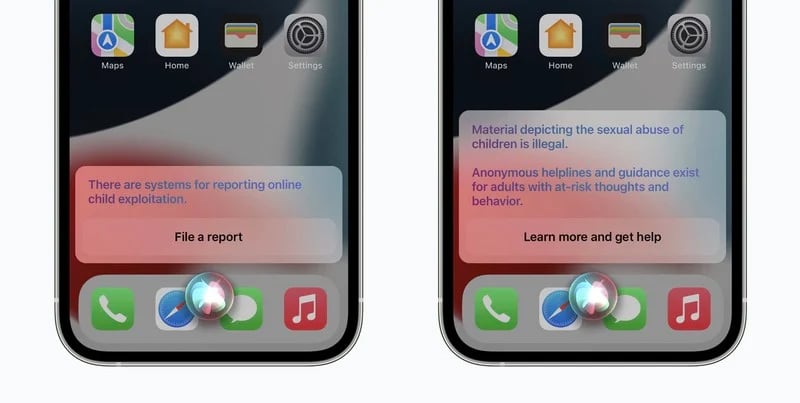

นอกจากนี้ ฟีเจอร์ดังกล่าวทาง Apple ก็จะนำมาใช้งานกับ Siri และการค้นหา (Spotlight) เช่นกัน โดยทั้งหมดนี้มีวัตถุประสงค์เพื่อความปลอดภัยของทั้งเด็กและผู้ปกครองบนโลกออนไลน์และในสถานการณ์ไม่ปลอดภัย